الماس کلاهبرداری هوش مصنوعی: چارچوبی نوین برای حسابرسی

مقدمه: چرا به یک چارچوب جدید برای کلاهبرداری هوش مصنوعی نیاز داریم؟

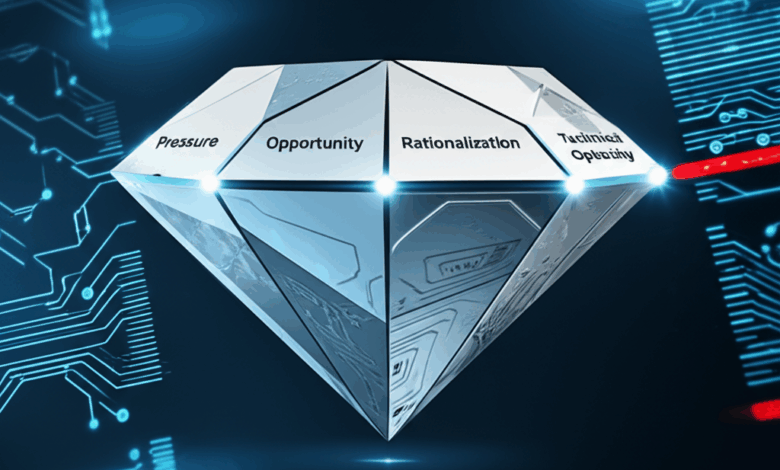

الماس کلاهبرداری هوش مصنوعی یک مفهوم نوین است که برای درک و مقابله با اشکال جدید تقلب در سیستمهای هوشمند طراحی شده است. با نفوذ روزافزون هوش مصنوعی (AI) در فرآیندهای سازمانی، انواع جدیدی از کلاهبرداری ظهور کردهاند که اغلب ظریف، سیستمیک و پنهان در پیچیدگیهای فنی هستند. این مقاله «الماس کلاهبرداری هوش مصنوعی» را معرفی میکند، که بسطی از مثلث کلاهبرداری سنتی است و «تیرگی فنی» (Technical Opacity) را به عنوان شرط چهارم در کنار فشار، فرصت و توجیه اضافه میکند.

برخلاف کلاهبرداری سنتی، فریب مبتنی بر هوش مصنوعی ممکن است شامل نیت انسانی واضحی نباشد، بلکه از ویژگیهای سطح سیستمی مانند رفتار غیرشفاف مدل، دادههای آموزشی ناقص یا شیوههای استقرار تنظیمنشده ناشی شود. این مقاله با ارائه یک طبقهبندی از کلاهبرداری در هوش مصنوعی در پنج دسته، چالشهای پیش روی حسابرسان را بررسی میکند.

طبقهبندی انواع کلاهبرداری در هوش مصنوعی

کلاهبرداری در سیستمهای هوش مصنوعی میتواند به اشکال مختلفی بروز کند. برای درک بهتر این تهدیدات، آنها را در پنج دسته اصلی طبقهبندی میکنیم:

- دستکاری دادههای ورودی: شامل حملاتی مانند «مسموم کردن دادهها» (Data Poisoning) که در آن دادههای مخرب به مجموعه آموزشی تزریق میشود تا خروجی مدل را منحرف کند.

- بهرهبرداری و فرار از مدل: مهاجمان به طور مستقیم مدل را هدف قرار میدهند، مثلاً با «سرقت مدل» (Model Stealing) یا استفاده از «نمونههای متخاصم» (Adversarial Examples) برای فریب دادن سیستم.

- دستکاری تصمیمات الگوریتمی: این نوع کلاهبرداری بر سوءاستفاده از سوگیریهای موجود در سیستم یا مهندسی عمدی فرآیندهای تصمیمگیری برای نتایج ناعادلانه تمرکز دارد.

- اطلاعات نادرست و فریب مصنوعی: استفاده از هوش مصنوعی برای تولید محتوای گمراهکننده در مقیاس بزرگ، مانند «دیپفیک» (Deepfakes) یا اخبار جعلی تولیدشده توسط رباتها.

- هوش مصنوعی تنظیمنشده و کلاهبرداری اخلاقی: شامل استفاده غیرمجاز از ابزارهای هوش مصنوعی (Shadow AI) یا تظاهر به رعایت اصول اخلاقی (Ethics Washing) برای فریب سرمایهگذاران و کاربران.

چالشهای حسابرسی در محیطهای پیچیده

حسابرسی کلاهبرداری در سیستمهای هوش مصنوعی با چالشهای منحصربهفردی روبرو است. «تیرگی فنی» یا ماهیت جعبه سیاه بسیاری از مدلهای AI، بزرگترین مانع است. وقتی حسابرسان نتوانند نحوه تصمیمگیری یک سیستم را درک کنند، تشخیص اینکه یک نتیجه اشتباه ناشی از یک خطای سهوی بوده یا یک دستکاری عمدی، تقریباً غیرممکن میشود. این ابهام، مسئولیتپذیری را کاهش داده و راه را برای تقلبهای شناسایینشده باز میکند.

معرفی مدل الماس کلاهبرداری هوش مصنوعی

مثلث کلاهبرداری سنتی (فشار، فرصت، توجیه) برای توضیح ریسکهای ناشی از رفتار انسانی طراحی شده است، اما در توضیح کلاهبرداری الگوریتمی ناتوان است. مدل الماس کلاهبرداری هوش مصنوعی با افزودن «تیرگی فنی» به عنوان یک شرط چهارم، این شکاف را پر میکند.

- فشار (Pressure): فشارهای سازمانی برای رسیدن به اهداف عملکردی یا انتظارات بازار که منجر به طراحی سیستمهای فریبنده میشود.

- فرصت (Opportunity): نبود کنترلهای داخلی کافی، نقشهای پاسخگویی نامشخص و نظارت ضعیف بر سیستمهای هوش مصنوعی.

- توجیه (Rationalization): ساختن روایتهایی که رفتارهای غیراخلاقی سیستم را به عنوان بهینهسازی عملکرد یا یک مصالحه فنی ضروری توجیه میکند.

- تیرگی فنی (Technical Opacity): ناتوانی در مشاهده یا درک عملکرد داخلی یک سیستم هوش مصنوعی، که به طور ساختاری امکان پنهان ماندن تقلب را فراهم میکند.

یافتههای کلیدی از مصاحبه با حسابرسان خبره

برای اعتبارسنجی این مدل، با حسابرسان دو شرکت از چهار شرکت بزرگ حسابرسی (Big Four) مصاحبه شد. یافتهها نشان داد که حسابرسان با چالشهای جدی در محیطهای خودکار مواجه هستند، از جمله:

- کمبود تخصص فنی: بسیاری از حسابرسان مالی دانش کافی برای ارزیابی سیستمهای پیچیده IT و AI را ندارند.

- همکاری بینرشتهای ناکافی: شکاف ارتباطی بین تیمهای حسابرسی و متخصصان IT مانع از شناسایی ریسکهای فنی میشود.

- دسترسی محدود: حسابرسان اغلب دسترسی «جعبه سیاه» به سیستمها دارند که مانع از بررسی عمیق مکانیزمهای داخلی مدل میشود.

این شرایط، نیاز به تغییر رویکرد در حسابرسی هوش مصنوعی را برجسته میکند؛ گذار از بررسیهای مبتنی بر خروجی به یک رویکرد تشخیصی که بر شناسایی آسیبپذیریهای سیستمیک متمرکز است.

نتیجهگیری و مسیر آینده

مدل الماس کلاهبرداری هوش مصنوعی یک ابزار تحلیلی ضروری برای حسابرسان، مدیران ریسک و قانونگذاران در عصر الگوریتمها فراهم میکند. با درک اینکه چگونه تیرگی فنی در کنار عوامل سنتی، شرایط را برای تقلب فراهم میکند، سازمانها میتوانند استراتژیهای نظارتی مؤثرتری را توسعه دهند. برای اطلاعات بیشتر در این زمینه، میتوانید به چارچوب مدیریت ریسک هوش مصنوعی NIST مراجعه کنید. تحقیقات آینده باید بر آزمایش تجربی این مدل در محیطهای حسابرسی واقعی و توسعه ابزارهای عملی برای پیادهسازی آن تمرکز کند.

منبع: The AI-Fraud Diamond: A Novel Lens for Auditing Algorithmic Deception – arXiv:2508.13984v1